“Apple” pateikė daugiau informacijos apie savo būsimus planus “iCloud Photos” naudotojų “iPhone” ir “iPad” nuskaityti “iCloud” nuotraukas ir jose ieškoti seksualinės prievartos prieš vaikus medžiagos (CSAM). Bendrovė paskelbė naują dokumentą, kuriame aptariamos apsaugos priemonės, kurios, kaip tikimasi, padidins naudotojų pasitikėjimą šia iniciatyva. Tarp jų – taisyklė, pagal kurią bus žymimi tik keliose vaikų saugumo duomenų bazėse, priklausančiose skirtingoms vyriausybėms, rasti vaizdai – taip teoriškai bus užkirstas kelias vienai šaliai į sistemą įtraukti ne CSAM turinį.

Būsimose “Apple” “iOS” ir “iPadOS” versijose JAV esančios “iCloud Photos” paskyros bus automatiškai sugretinamos su žinomais CSAM iš vaikų saugumo grupių sudaryto vaizdų hash sąrašo. Nors daugelis bendrovių nuotoliniu būdu skenuoja debesų saugyklų paslaugas, “Apple” strategija, pagrįsta įrenginiais, sulaukė aštrios kai kurių kriptografijos ir privatumo ekspertų kritikos.

Dokumente, pavadintame “Apple” vaikų saugos funkcijų saugumo grėsmių modelio apžvalga”, tikimasi išsklaidyti su privatumu ir saugumu susijusius nuogąstavimus. Jis parengtas remiantis “Wall Street Journal” interviu su “Apple” vadovu Craigu Federighi, kuris šį rytą pateikė dalį informacijos.

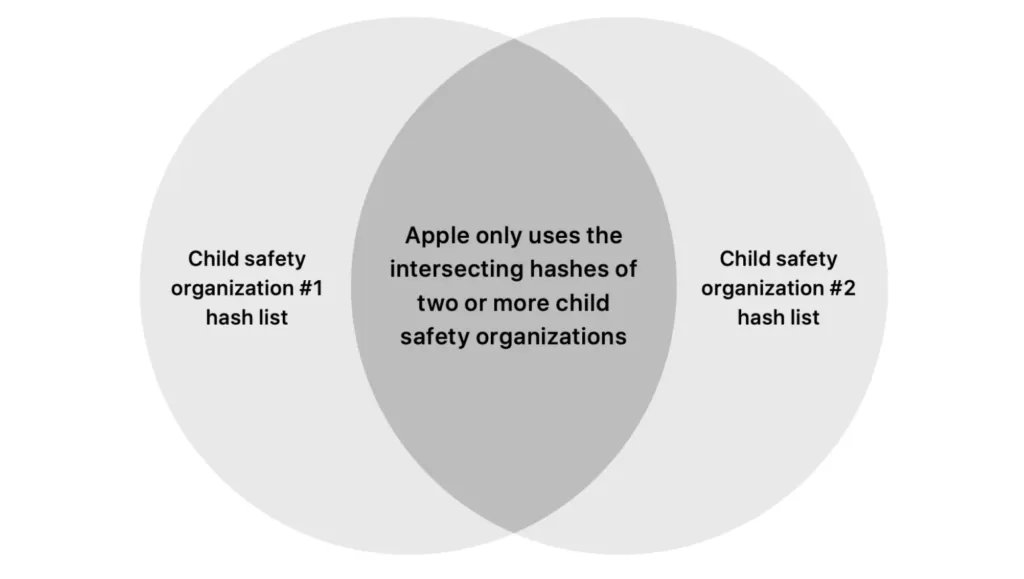

Dokumente “Apple” teigia, kad nustatydama CSAM nesirems viena su vyriausybe susijusia duomenų baze, pavyzdžiui, JAV įsikūrusio Nacionalinio dingusių ir išnaudojamų vaikų centro (National Center for Missing and Exploited Children, NCMEC) duomenų baze. Vietoj to ji derins nuotraukas tik iš mažiausiai dviejų grupių, turinčių skirtingas nacionalines priklausomybes. Taip siekiama, kad nė viena vyriausybė negalėtų slapta įterpti nesusijusio turinio cenzūros tikslais, nes jis nesutaptų su hash’ais jokioje kitoje duomenų bazėje.

“Apple” užsiminė apie galimą kelių vaikų saugos duomenų bazių naudojimą, tačiau iki šiol nepaaiškino, kokia sistema sutampa. Per pokalbį su žurnalistais “Apple” teigė, kad NCMEC įvardija tik dėl to, kad dar nebaigė rengti susitarimų su kitomis grupėmis.

Dokumentas patvirtina Federighi minėtą detalę: iš pradžių “Apple” pažymės “iCloud” paskyrą tik tuo atveju, jei identifikuos 30 vaizdų kaip CSAM. Dokumente teigiama, kad ši riba pasirinkta siekiant užtikrinti “drastišką saugumo ribą”, kad būtų išvengta klaidingų teigiamų rezultatų, o įvertinus sistemos veikimą realiame pasaulyje, “mes galime pakeisti šią ribą”.

Jame taip pat pateikiama daugiau informacijos apie audito sistemą, kurią minėjo Federighi. “Apple” žinomų CSAM hešų sąrašas bus įtrauktas į “iOS” ir “iPadOS” visame pasaulyje, nors skenavimo sistema kol kas veiks tik JAV. Apple pateiks visą hash’ų sąrašą, kurį auditoriai galės patikrinti vaikų saugos duomenų bazėse – tai dar vienas būdas įsitikinti, kad slapta nesutampa daugiau vaizdų. Be to, ji teigia, kad “atmes visus prašymus”, kad moderatoriai praneštų apie “bet kokią kitą nei CSAM medžiagą”, skirtą pažymėtoms paskyroms, – taip užsimenama apie galimybę šią sistemą naudoti kitoms sekimo rūšims.

Federighi pripažino, kad “Apple” savo praėjusios savaitės pranešimu įnešė “sumaišties”. Tačiau pati “Apple” pasiliko prie atnaujinimo – žurnalistams ji sakė, kad nors vis dar derina ir tikslina detales, tačiau reaguodama į praėjusios savaitės kritiką savo paleidimo planų nepakeitė.

Daugiau naujienų

„Microsoft“ žaidimų pajamos padidėjo 61 %, nes dėmesio centre atsidūrė debesų kompiuterija ir dirbtinis intelektas.

„Black Ops 6“ pasiekė didžiausią premjerinį savaitgalį ‚Call of Duty‘ istorijoje

Dauguma dabartinių dirbtinio intelekto technologijų yra 90 proc. rinkodaros, sako Linusas Torvaldsas